Robots.txt是在搜索引擎优化(SEO)世界中必须多次听到的文件名。如果您想知道robots.txt是什么以及如何创建robots.txt,则必须到正确的位置。在这篇文章中,我们讨论什么是robots.txt,为什么需要一个robots.txt,以及如何轻松为您的网站创建robots.txt文件。

什么是Robots.txt?

尝试将robots.txt理解为与“ sitemaps”相反。

当搜索引擎经常访问您的网站并对其进行爬网以在搜索引擎结果页面中为内容建立索引时,这显然非常好,但有时可能不是您想要的。

有时,您可能不希望搜索引擎蜘蛛程序访问您的网站并为网站的某些内容或部分编制索引。可能有几个原因。我们将很快进入这些原因。

目前,原因并不重要。重要的是如何阻止搜索引擎蜘蛛程序不访问网站的某些部分。这可以通过robots.txt文件来完成。

就像站点地图告诉搜索引擎要索引的内容一样,robots.txt告诉搜索引擎不要在搜索引擎结果页中建立索引的内容。

它是上传到网站主目录的纯文本文件。robots.txt文件具有搜索引擎蜘蛛程序可以理解的特定说明。通常,robots.txt文件包含您不希望搜索引擎机器人访问并在搜索引擎中建立索引的所有URL的列表。

创建Robots.txt的原因

如前所述,有人要创建robots.txt文件并停止搜索引擎蜘蛛程序来访问和索引您网站的某些部分,有多种原因。

此外,阻止搜索引擎蜘蛛程序将您的网站编入索引似乎会适得其反,但实际上并非如此。在大多数情况下,出于逻辑原因,您不希望这样做,这就是为什么您遇到的几乎每个网站都带有robots.txt的原因。

以下是您可能需要robots.txt的一些最常见的原因。

避免浪费服务器资源。搜索引擎抓取工具抓取您的网站时,会要求提供robots.txt。而且当他们找不到robots.txt文件时,它们会在日志中生成错误-最终导致服务器资源的浪费。

节省带宽。由于robots.txt可以指定您不想索引的页面,因此可以通过阻止搜寻器不必要地爬网那些网页来节省大量宝贵的带宽。

为了避免网络统计信息混乱。

拒绝不良的机器人和行为不良的蜘蛛访问您网站的内容。

为了保护您不想在搜索引擎中建立索引的有关您网站的敏感信息。

如何创建Robots.txt?

现在您知道了robots.txt是什么,并且拥有它的一些逻辑原因,让我们看看如何为您的网站创建robots.txt文件。

首先,重要的是要知道在哪里可以找到robots.txt文件。

它应始终位于网站的根文件夹中。因此,如果它不在网站的根文件夹中,则需要创建一个并将其放置在网站中。您可以使用简单的FTP客户端来实现。

robots.txt文件是一个基于文本的简单文件,您可以使用记事本或任何其他纯文本编辑器打开该文件。

如何创建一个?

只需打开记事本(或任何其他纯文本编辑器),创建一个新文件,并将其保存为robots.txt。然后,您可以将该文件上传到网站的根文件夹。

但是拥有一个空的.txt文件不会做很多事情,对吧?这就是为什么您需要一些代码来帮助搜索引擎蜘蛛程序了解您希望它们执行的操作的原因。

让我们看看语法如何工作:

第一行通常是用户代理的名称。换句话说,它是您试图与robots.txt文件进行通信的搜索引擎机器人的名称。您应使用“ *”(星号)与所有机器人进行通信。另一方面,您也可以选择特定的搜索引擎机器人,例如Googlebot。

接下来的几行很不言自明。它们包含要允许或不允许的文件和路径的说明。例如,在上面的示例中,您正在指示并允许所有漫游器索引图像上载目录。同样,在接下来的几行中,您还将禁止所有漫游器为插件和readme.html文件建立索引。

不同的网站可能具有外观不同的robots.txt文件。这完全取决于您的特定需求和要求。而且,您还应该根据需要设置robots.txt文件。

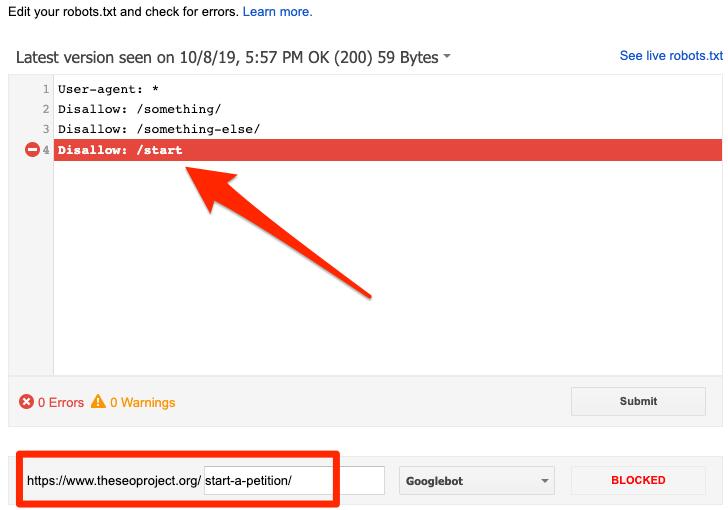

测试您的Robots.txt文件

创建完robots.txt文件后,检查语法始终是一个好主意。它可以确保搜索引擎蜘蛛程序无法访问您不想访问的URL和网站的特定内容。

百度资源平台有一个简单的工具,可让您检查语法并识别robots.txt文件可能存在的任何错误。

要访问该工具,请打开百度搜索资源平台从左侧栏中选择“搜索服务”标签,然后单击“ Robots”。

仔细检查文件

在上传robots.txt文件之前,请务必仔细检查代码。确保您已彻底检查并确认robots.txt文件中包含的URL。

有时,您可能最终阻止了您确实不想要的URL。因此,最好仔细检查该文件,以确保您不会意外阻止搜索引擎蜘蛛程序访问任何重要的网页或URL。

请记住,robots.txt文件中提到的URL可能不会在搜索引擎中排名。

最后的话

如本博文所述,创建robots.txt文件的原因很多。几乎每个网站都有一个。

首先,确定您希望搜索引擎索引的内容和不索引的内容。然后根据上述语法创建robots.txt文件。使用robots.txt测试器检查语法,然后仔细检查以确保您不会意外阻止网站的重要部分。

使用纯文本编辑器创建文件并完成文件确定后,将其上传到网站的根目录。就是这样。

SEO服务

SEO服务 网站建设

网站建设 软文营销

软文营销 网站认证

网站认证 小程序开发

小程序开发